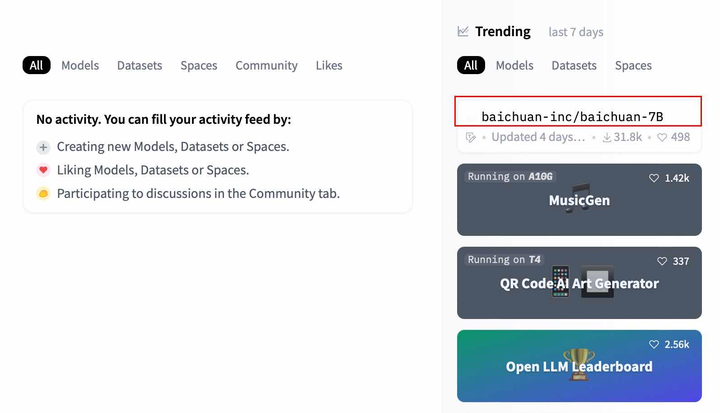

6月15日,百川智能推出了参数量为7B的中英文预训练大模型—baichuan-7B,并于同日开源到Github、Huggingface、Modelscope三个平台。仅仅过去了6天时间,baichuan-7B便登上了HuggingFace Trends的榜首,引发大量开发者的关注和使用。

截止今日,在HuggingFace上baichuan-7B的下载量共计31,845次,获赞量近五百个,并登上了第一名的位置,此前HuggingFace Trends的榜首长期被ChatGLM模型霸占。

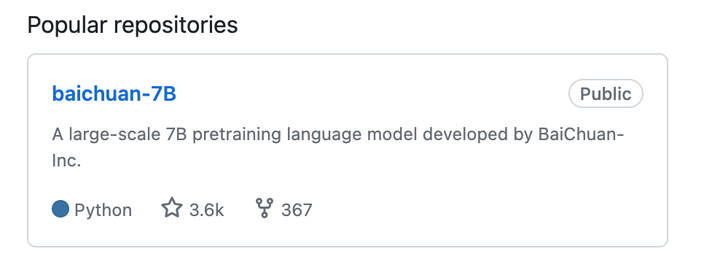

在另一主流开源平台Github上,baichuan-7B同样受到了开发者们的热捧,标星超过3.6K,并获得了367个Fork。

作为百川智能成立之后推出的首款自研中英文大模型,baichuan-7B能够在众多同规模的产品中脱颖而出,受到开发者们的追捧,与其强大的性能密不可分。

多个评测榜单中文成绩最佳,英文成绩同样优秀

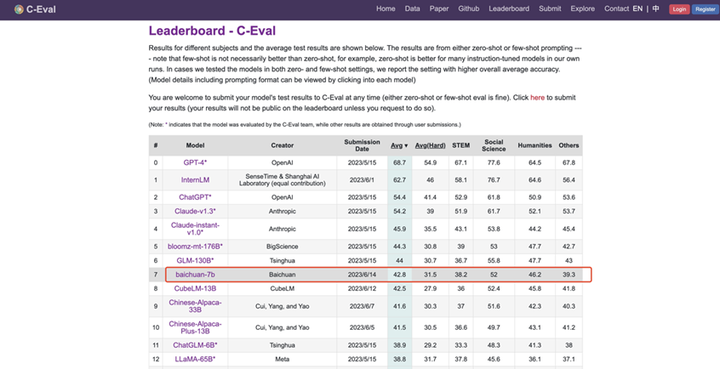

以榜单评测来验证一款大模型的能力各项能力是最直观也最有说服力的方式。baichuan-7B在C-Eval、AGIEval和Gaokao三个最具影响力的中文榜单的综合评估中均获得了优异成绩,不仅远超其他同规模参数的大模型,甚至比某些参数规模更大的模型还要出色。

在C-EVAL的评测中,baichuan-7B以42.8分的综合评分,领先于ChatGLM-6B和LLaMA-65B,后两者的得分分别为38.9分和38.8分。

在AGIEval的评测里,baichuan-7B综合评分达到34.4分,远超LLaMa-7B、Falcon-7B、Bloom-7B以及ChatGLM-6B等其他开源模型。

在GAOKAO评测中,baichuan-7B的综合评分达到36.2分,大幅领先其他同参数规模的预训练模型。

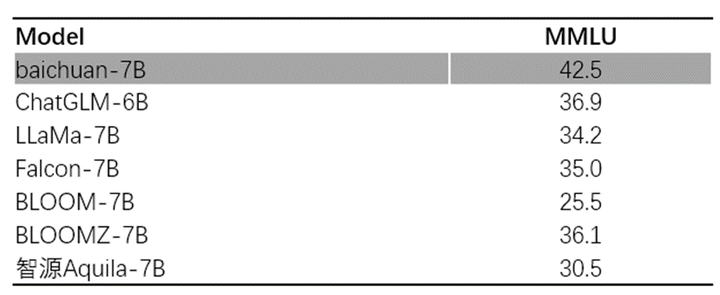

不仅如此,baichuan-7B在英文评测上表现同样出色。在MMLU的评测中综合评分高达42.5分,远超英文开源预训练模型LLaMa-7B的34.2分以及中文开源模型ChatGLM-6B的36.9分。

万亿优质数据,训练高效稳定

训练语料对大模型的训练结果至关重要。百川智能以高质量中文语料为基础,融合优质的英文数据,为baichuan-7B构建了包含1.2万亿token的预训练语料库方面。

其原始数据由海量中英文互联网数据,部分开源的中英文数据,以及大量高质量知识性数据组成。在此基础上,百川智能通过质量模型对数据进行打分,对原始数据集进行篇章级和句子级的精确筛选。

同时,利用自研超大规模局部敏感哈希聚类系统和语义聚类系统,百川智能还对数据进行了多层次多粒度的聚类,兼顾了预训练数据的质量和多样性。相较于其他同参数规模的开源中文预训练模型,baichuan-7B数据量提高了超过50%。

构建好数据库之后,为了更好地提升训练效率,baichuan-7B深度整合了模型算子来加快计算流程,并针对任务负载和集群配置,自适应优化了模型并行策略以及重计算策略。通过高效的训练过程调度通信,其成功地实现了计算与通信的高效重叠,进而达到了超线性的训练加速,在千卡集群上训练吞吐达到180+Tflops的业界领先水平。

此外,baichuan-7B还对模型训练流程进行了深度优化,采用了更科学且稳定的训练流程和超参数选择,使得 baichuan-7B模型的收敛速度大大提升。与同等参数规模的模型相比,baichuan-7B在困惑度(PPL)和训练损失(training loss)等关键性能指标上表现更加优秀。

免费可商用,模型部署和应用成本低

能够免费商用是baichuan-7B吸引广大开发者的另一个重要因素。baichuan-7B代码采用Apache-2.0协议,模型权重采用了免费商用协议,只需进行简单登记即可免费商用。

与此同时,baichuan-7B开源的内容也十分丰富,包含了推理代码、INT4量化实现、微调代码,以及预训练模型的权重。其中,微调代码方便用户对模型进行调整和优化;推理代码与INT4量化实现则有助于开发者低成本地进行模型的部署和应用;预训练模型权重开源后,用户则可以直接使用预训练模型进行各种实验研究。

作为国内最受关注的大模型团队之一,百川智能成立之后仅用两个月的时间便推出了7B规模的大模型,并且开源之后不到一周时间便在两个主流平台受到开发者的热捧。本次推出的baichuan-7B不仅证明了其强大的团队协作和技术创新能力, 更展现出了其致力于推动AGI发展的理念。

免责声明:市场有风险,选择需谨慎!此文仅供参考,不作买卖依据。