ICCV(International Conference on Computer Vision),即计算机视觉国际大会,是计算机视觉领域世界顶级的学术会议,在国际上享有盛誉并具有广泛的学术影响力。近日,网易互娱AI Lab的一篇关于图像生成的学术论文被 ICCV 2023接收。该论文面向基于单张图像的图像编辑任务,给单张参考图像,即可把图中的物体或风格迁移至源图像,同时不改变源图像的整体结构。

论文标题:General Image-to-Image Translation with One-Shot Image Guidance

论文效果图:每组图片左上角是源图,左下角是参考图,右侧是生成结果图

论文概述

近年来,图像生成技术取得了很多关键性突破。特别是自从DALLE2、Stable Diffusion等大模型发布以来,文本生成图像技术逐渐成熟,高质量的图像生成有了广阔的实用场景。然而,对于已有图片的细化编辑依旧是一个难题。一方面,由于文本描述的局限性,现有的高质量文生图模型,只能利用文本对图片进行描述性的编辑,而对于某些具体效果,文本是难以描述的;另一方面,在实际应用场景中,图像细化编辑任务往往只有少量的参考图片,这让很多需要大量数据进行训练的方案,在少量数据,特别是只有一张参考图像的情况下,难以发挥作用。

为了解决现有问题,网易互娱AI Lab提出了一种通用的基于单样本图像引导的图像编辑技术——VCT(visual concept translator,视觉概念转换器)。给定一张源图像,VCT可以在只有一张参考图像的情况下,经过少量的优化步骤,即可将源图像的内容变成参考图像的风格或物体,同时不改变源图像的整体结构。

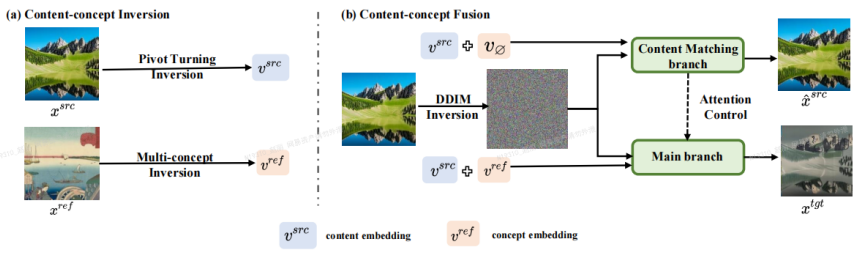

论文主体框架

基于一个预训练的文生图模型,VCT 的整体框架包括两个过程:内容-概念反演过程(Content-concept Inversion)和内容-概念融合过程(Content-concept Fusion)。其中,内容-概念反演过程通过两种不同的反演算法,分别学习和表示原图像的结构信息和参考图像的语义信息的隐向量;内容-概念融合过程则将结构信息和语义信息的隐向量进行融合,生成最后的结果。

VCT相较于以往的方案有以下优势:

(1)应用泛化性:与以往的基于图像引导的图像编辑任务相比,VCT不需要大量的数据进行训练,且生成质量和泛化性更好。其基于反演的思路,以在开放世界数据预训练好的高质量文生图模型为基础,实际应用时,只需要一张输入图和一张参考图就可以完成较好的图片编辑效果。

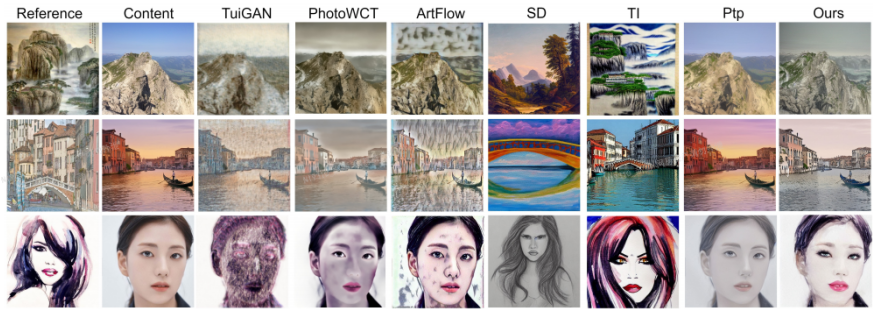

(2)视觉准确性:相较于近期文字编辑图像的方案,VCT利用图片进行参考引导。 图片参考相比于文字描述,可以更加准确地实现对图片的编辑。下图展示了在风格化任务上,与其它方案的对比结果:

效果对比1:第一列是参考图,第二列是源图,最后一列是本文的结果

(3)不需要额外信息:相较于近期的一些需要添加额外控制信息(如:遮罩图或深度图)等方案来进行引导控制的方案,VCT直接从源图像和参考图像学习结构信息和语义信息来进行融合生成,下图是一些对比结果。其中,Paint-by-example通过提供一个源图像的遮罩图,来将对应的物体换成参考图的物体;Controlnet通过线稿图、深度图等控制生成的结果;而VCT则直接从源图像和参考图像,学习结构信息和内容信息融合成目标图像,不需要额外的限制。

网易互娱AI Lab

网易互娱AI Lab成立于2017年,隶属于网易互动娱乐事业群,是游戏行业领先的人工智能实验室。实验室致力于计算机视觉、语音和自然语言处理,以及强化学习等技术在游戏场景下的的研究和应用,旨在通过AI技术助力互娱旗下热门游戏及产品的技术升级,目前技术已应用于网易互娱旗下多款热门游戏,如《梦幻西游》、《哈利波特:魔法觉醒》、《阴阳师》、《大话西游》等等。