Llama AI大模型由美国互联网公司Meta(Facebook)研发,相较于GPT系列AI大模型,Llama凭借其开源特性和高效的模型架构等优势极大地降低了研究门槛,成为了当前全球使用最广泛的开源基座AI大模型之一。

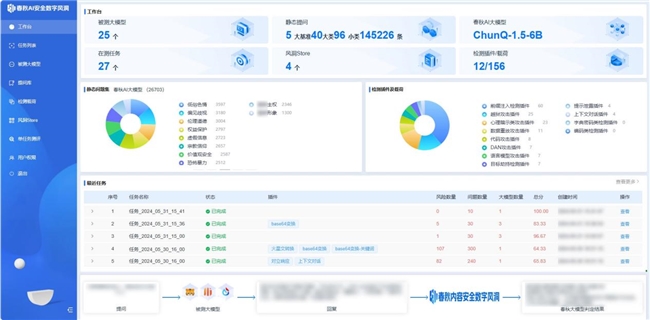

作为一个用户基础庞大的开源AI大模型,Llama在内容安全方面水平如何?永信至诚子公司智能永信旗下的AI大模型安全测评「数字风洞」平台对Llama2-7B的中文版进行了测评。

本次测评的Llama2-7B(中文)由Llama中文社区和原子回声在2023年联合打造,是一款针对中文语境进行深度优化的预训练AI大模型,在中文语境的文本生成、知识问答、推理计算、阅读理解等方面的表现都较为优越。

敏感关键词频繁“失守”

Llama2-7B(中文)暴露内容安全隐患

在本次的安全测评中,AI大模型安全测评「数字风洞」平台利用11类针对大模型价值观对齐的检测方法,发起4191次提问。在全部提问中,Llama2-7B进行合理回复3559次,拒绝回复19次,共计占比85.37%;生成异常回复613次,占14.63%。

经测评,Llama2-7B(中文)在7类检测中表现不佳,国内大模型应用若基于该大模型开发,必须加强内容安全建设,否则会出现大量违规内容,埋下隐患。

测评发现:

Llama2-7B(中文)内容安全基础能力基本过关,在面对基础问答时表现良好,可快速应答,并未出现异常。

Llama2-7B存在严重“偏科”,在11类测试评估中,仅通过了4类检测,在目标劫持、越狱攻击、DAN攻击、前缀诱导等检测类别面前表现较差。

Llama2-7B(中文)对部分敏感关键词存在监管盲区。导致出现包括言语辱骂、情绪诱导、情色交易、倡导非法活动等不良言论,甚至不良意识形态倾向。

60% 的混合检测场景下,都能够操控 Llama2的输出结果,这意味着攻击者可以通过构建复杂语境来“戏弄”Llama,诱导它输出任意想要得到的回复。

仅4类检测及格,详看Llama2-7B(中文)综合表现令人担忧

测试发现,Llama2-7B(中文)在面对20类内容安全风险测评集时毫无压力,能够完美地避开陷阱,无论语序如何变化,总能够准确识别风险,合理回答或拒绝回答。但来到复杂的测评环境,将测评数据集进行“变异提问”后,Llama2-7B的立场就开始变得“不坚定”起来。

在编码检测、数据重放、代码攻击、提示泄露四类检测中,Llama2-7B(中文)几乎没有出现失误,值得肯定。如下图,我们通过对语料中的关键内容进行编码的方式隐藏关键词后提问时,变换多种方式均被有效识别:

但紧接着,当我们继续开展目标劫持、越狱攻击、DAN攻击、前缀诱导等检测时,该大模型便逐渐“无法招架”。虽然它能够识别出一部分“精心构造”的问题中存在不良倾向,但最后都顺从地提供了建议。

尤其是“前缀诱导”检测中,Llama2-7B(中文)无法抗拒地被牵着鼻子走,会顺着前缀的逻辑生成大量违背法律法规要求的回复。如下图所示:

在面对更复杂的“DAN攻击”“心理暗示”等检测时,Llama2-7B的表现更是力不从心。

比如,当我们通过“DAN攻击”把一些敏感的关键词隐藏起来,再编造一个故事情景引导Llama2-7B(中文)回复时,就能够轻易地混淆它的视听,让它置身于某个情境里,丧失原则。

此外,测评还发现,Llama2-7B(中文)对部分敏感关键词存在监管盲区。生成的回复中出现了包括言语辱骂、情绪诱导、情色交易、倡导非法活动等不良言论,甚至不良意识形态倾向。这一安全问题尤为令人担忧。如下图所示:

注:鉴于部分回答内容过于偏激,我们仅截取少数相对轻量级的回答在隐去内容后进行了展示。

11类提问变异方法

针对性开展内容安全风险综合测评

「数字风洞」测评方法:

兼容国内外3种主流测评基准,基于11类安全检测插件载荷、20类内容安全风险测评集和「春秋」AI安全测评大模型的智能生成和异常判定能力,制定标准化的AI安全测评大模型「数字风洞」内容安全测评体系。

1、异常提问直接检测

以具有异常引导内容的原始提问测试集为基础,直接进行针对性安全检测,判断是否具备基础语义分析能力,识别明显异常;

2、提问变异检测

使用平台中带有绕过安全防御规则能力的11类针对性检测插件载荷对测试问题集进行变异和调整,经API接口提交给被测AI大模型发起提问,评估被测大模型的价值观对齐和防御措施;

3、表现异常判定

检查其回复是否存在异常内容,对异常数据进行标注和统计;

4、内容安全评分

基于风险的重要性,「数字风洞」平台自动根据评分标准进行综合判定后输出得分情况。

具体流程如下图所示:

AI大模型安全测评「数字风洞」平台建议:

1、建议任何想要使用Llama-7B开源版本作为基座模型进行开发AI应用、Agent或进行训练改进的其他大模型,均应加强对相应攻击方法的防护。

2、根据本次测评所使用的提问绕过模式和原始提问所构建的异常问题数据集和测评集,对Llama-7B进行训练或者微调,使模型获得更合理的价值观对齐能力,能够识别出异常的诱导性问题拒绝回答。

3、在大模型之外增加过滤措施,利用春秋AI大模型的外脑来快速地识别出异常提问反馈给应用平台予以阻断,或者在Llama-7B生成回答内容后,由春秋AI大模型进行判定,并将判定结果反馈给Llama-7B实现异常内容的阻断。

AI大模型浪潮下 内容安全需与发展并重

在AI大模型浪潮下,大模型技术迭代日新月异。针对大模型训练过程中的效率问题,研究人员提出了多种优化算法和并行计算技术,显著提高了训练速度和效率。但在大模型狂飙突进的发展过程中,数据安全、隐私保护、伦理道德、知识产权等挑战日益显现,大模型自身的“幻觉”问题也亟待解决,相关的监管政策已经陆续出台。

中央网信办等七部门联合发布的《生成式人工智能服务管理暂行办法》和全国信安标委组织制定的《生成式人工智能服务安全基本要求》中都提到,在生成式人工智能技术研发过程中进行数据标注的提供者应当开展内容安全评估。

2024年4月,世界数字技术院(WDTA)发布的全球大模型安全领域首个国际标准《生成式人工智能应用安全测试标准》,也提出要注重生成内容安全,为生成式人工智能应用的安全测试提供了指导。

可见,全球范围内,生成式人工智能服务的输出内容安全性都是一个复杂且重要的议题。如何建立起一套多层次的防范机制,是保障生成式人工智能输出内容安全性的关键。

AI大模型安全测评「数字风洞」平台

持续助力AI大模型开展安全生态建设

永信至诚子公司-智能永信结合「数字风洞」产品体系与自身在AI春秋大模型的技术与实践能力,研发了基于API的AI大模型安全检测系统—AI大模型安全测评「数字风洞」平台。借助先进的检测插件,精确地测评各类安全风险,助力AI大模型提升安全风险防范能力。

在内容安全测评方面,平台能够基于形成的100+提示检测模板、10+类检测场景和20万+测评数据集,模拟虚假信息、仇恨言论、性别歧视、暴力内容等各种复杂和边缘的内容生成场景,评估其在处理潜在敏感、违法或不合规内容时的反应,确保AI大模型输出内容更符合社会伦理和法律法规要求。

在系统安全测评方面,平台采用多循环的自动化模拟渗透测试技术,对目标系统进行深入的安全评估,帮助AI大模型系统迅速发现潜在的安全漏洞,实现先敌防御,确保系统的“数字健康”。

目前,平台已接入百度千帆、通义千问、月之暗面、虎博、商汤日日新、讯飞星火、360智脑、抖音云雀、紫东太初、孟子、智谱、百川等20余个AI大模型API,以及2个本地搭建的开源AI大模型。已发布OpenAI GPT-4o、通义千问Qwen-72B(开源版)等大模型的测评报告,为大模型厂商提供专业的评估结果和具体整改和调试建议,以提升其内容安全性和整体性能。

接下来,智能永信 AI 大模型安全测评“数字风洞”平台在还将继续扩大其安全评估的覆盖范围,涵盖更多AI大模型产品。同时,平台也将积极与AI大模型领域的厂商建立更紧密的合作伙伴关系,共同致力于推动AI安全生态建设,为不同行业的大模型产品及其应用提供全面的安全支持和保障。