近日,在第二届多模态情感识别挑战赛(MER24)上,Soul App语音技术团队(Soul AI)在SEMI(半监督学习)赛道获得第一名。

国际人工智能联合会议(International Joint Conference on Artificial Intelligence,IJCAI)是人工智能领域顶级的国际学术会议之一,也是中国计算机学会(CCF)推荐的A类会议。为促进情感计算在人机交互领域的发展,深入探讨该领域最新研究进展、未来发展方向和技术在真实场景中的落地应用,来自清华大学、中国科学院自动化研究所、帝国理工学院、奥卢大学、南洋理工大学等高校的多位专家学者联合在IJCAI2024上举办多模态情感识别挑战赛MER24,并在ACM国际多媒体会议(ACM International Conference on Multimedia,ACM MM 2024)上组织多模态与可靠性情感计算研讨会MRAC24(Multimodal, Generative and Responsible Affective Computing 2024)。

此次多模态情感识别挑战赛(MER24)上,设置了SEMI(半监督学习)、NOISE(噪声鲁棒性)、OV(开放式词汇情绪识别)三个赛道,共吸引了来自知名高校、科技企业等近百支参赛队伍。

其中,SEMI赛道旨在探索和改进半监督学习策略,以便更好地利用未标记数据来提高情绪识别的性能。因当前在实际应用中,获取大量带有情绪标签的数据是困难且成本高昂的,半监督学习是一种减少对标记数据依赖的方法,因此SEMI为大赛中颇受关注、参赛队伍最多且难度高的赛道,Soul语音技术团队凭借平台扎实的技术能力积累和创新技术方案在此赛道中获得第一名。

一直以来,多模态情感识别在人工智能领域都是一个活跃的研究课题,它的主要目标是整合多种模态来识别人类的情绪状态。特别是在社交领域,多模态情感识别技术更是重要的一环。社交的本质是情感的流动,只有能够实现情感的识别,才能让AI更好的理解人性、情绪和情感,实现理想的人机互动。

Soul定位为新型开放式社交平台,致力于用底层技术和产品模式创新持续提升用户的社交体验。自2016年上线,Soul便不断思考AI在社交场景的具体落地应用。2020年,Soul启动对AIGC的技术研发工作,系统推进在智能对话、图像生成、语音&音乐生成等AIGC关键技术能力研发工作。为了让AI更能理解情绪,为用户带来更好的情绪反馈和陪伴感,情感识别是Soul技术团队关注的焦点之一。

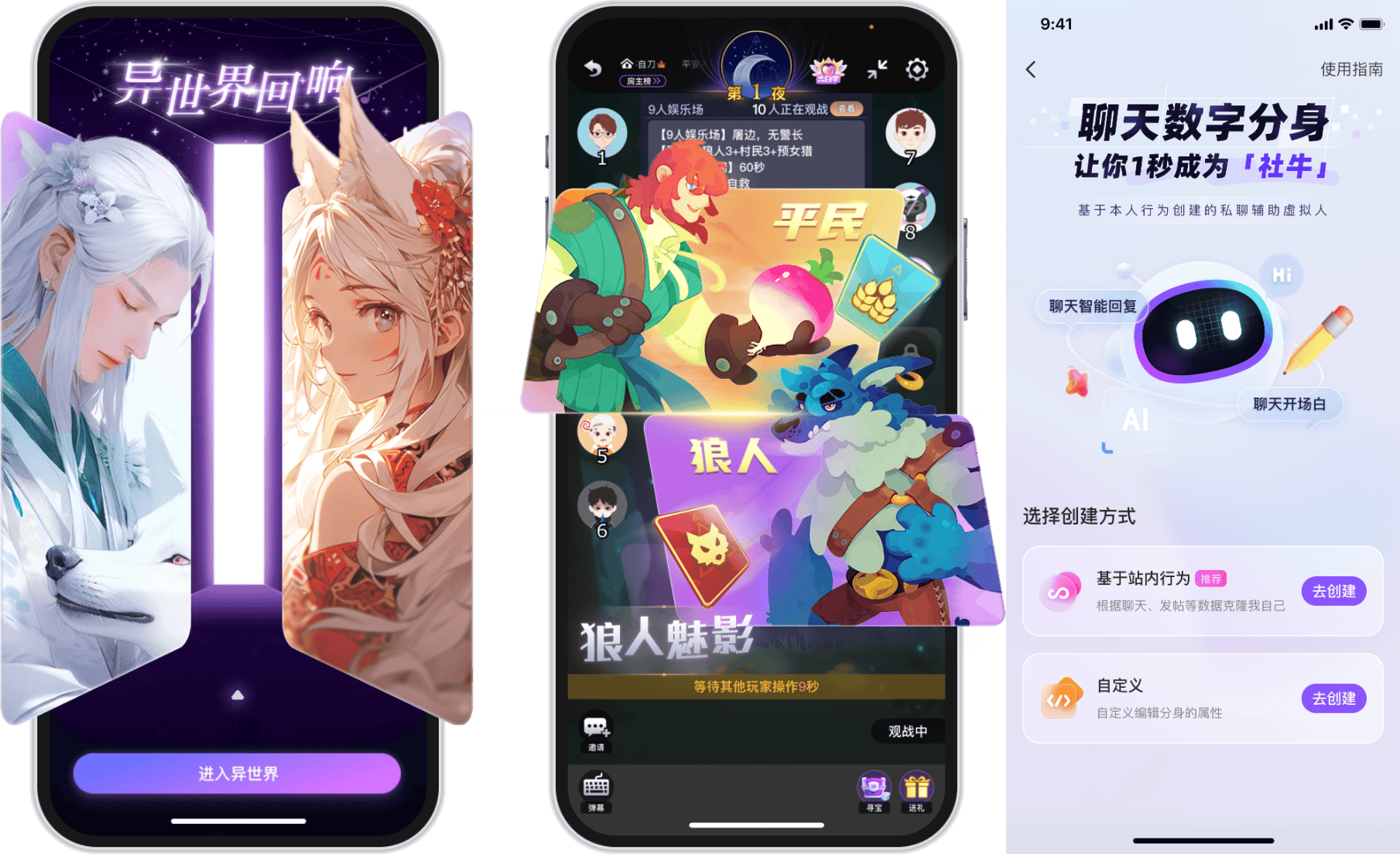

目前,Soul具备多模态情感识别能力的语言大模型 Soul X、语音大模型均已上线,并推出了“AI苟蛋”“狼人魅影”“异世界回响”等功能/产品,相关技术已在AI辅助社交、AI陪伴、AI游戏等多个创新场景中得到应用。

在第二届多模态情感识别挑战赛(MER24)上,基于目前平台自研大模型部分模块,Soul语音技术团队重新调整了创新方案参赛,包括提出微调模型EmoVCLIP,用于适应视频的情感识别;使用Self-training策略,通过循环对无标签数据打伪标签与训练模型之间相互迭代从而提升模型的泛化性能;针对模型不同模态之间融合存在的竞争效应,首次在多模态情感识别领域使用Modality Dropout,有效提高模型情感识别准确率等,最终凭借极高的准确性和泛化性能在比赛中获胜。

现阶段,让AI“理解”人、实现有情感的人机交互已经成为学界、科技领域关注的焦点。在近日举办的ChinaJoy AIGC大会上,Soul 副总裁及产品负责人车斌表示,相比“智商”,社交领域更需要有“情商”的大模型,即需要多模态的、具备拟人化属性,确保实现情感化、个性化和生活化。

此次多模态情感识别挑战赛上取得成绩,在国际赛事舞台上展现了Soul的前沿洞察和技术能力。接下来,Soul在推进AIGC在社交场景落地的探索中,将进一步利用多模态情感识别技术能力,让AI辅助社交、提升关系建立的质量和效率的同时,构建人机交互新场景,让用户可以与AI进行更加有温度、沉浸、趣味的互动交流。

免责声明:市场有风险,选择需谨慎!此文仅供参考,不作买卖依据。