新华三集团副总裁、互联网事业部总经理李乔

1、AGI,路还长!

最近和一些朋友聊天,他们很容易将AIGC和AGI混淆,其实当下主要的爆款模型或应用只是AIGC范畴,而AGI的目的是实现真正的自主学习和创造,其核心是让计算机具备人类般的智能,能够像人类一样学习、思考和解决问题。那么,我们距离AGI还有多远?OpenAI CEO阿尔特曼在一次采访中提到,AGI可能在五年内实现。与阿尔特曼不谋而合的还有英伟达的CEO黄仁勋,他在近期的一个论坛上表示:如果把AGI标准定为通过人类创制的各种测试的话,那么预计5年左右时间,AI就可以通过任何人类测试。因此,AI还有很长的路要走。

前阵子我参加了WAIC2024,会上各行业领军人围绕“应用-模型-算力”几个维度展开了激烈讨论。但是整场会议听下来,真正谈算力基础设施的话题并不多,然而我认为这反而是影响当下中国AI发展的关键因素。所以本文我们重点谈谈国内AI Infra的这条长路上的几座大山如何翻!

2、国内AI Infra路上的大山

一、X因素影响先进AI芯片的供应与设计

由于一些众所周知的因素,供应到国内的AI芯片从单芯片晶体管数量、算力密度、联接带宽等方面均受影响,国内芯片的流片同样受限。这不禁让我联想到一部著名小说《三体》中的“智子”,“智子”不但时刻监控地球状态,更甚者进入对撞机代替质子进行撞击从而锁死地球基础科学,这与我们当下的处境“异曲同工”…

二、智算市场乱象丛生,算力资源、算力生态碎片化

智算中心作为人工智能产业发展的重要底层基础设施形态,正在成为建设的热点。热钱的涌入导致了一窝蜂上马的现象,但很多项目都是以供应能力作为依据进行建设,缺乏全盘的统筹。资源分布散碎,配置型号不一,难以形成规模效应,使得算力的整合与优化变得异常困难。由于难以进行规模化集群交付和资源统筹,在AI计算资源如此紧张的当下,甚至出现了很多智算中心AI服务器空转、停机的现象。

同时,各芯片厂商忽视上层应用迁移及兼容程度,导致算力系统的应用效率偏低。每个智算厂商都有一套独立的开发环境和生态系统,生态研发投入较为碎片化。相较于CUDA生态2万余开发人员,550个SDK,每年50亿美金的开发费用投入,是我们国家所有AI芯片公司生态投入总和的几十倍甚至上百倍。生态资源的分散很难形成规模效应,为开发人员和实际大模型的迁移部署带来数倍工作量的增加。

三、面向大规模的AI应用场景,算力能效比亟待提高

算力的尽头是电力。预计到2025年,国内数据中心用电量占全社会用电量的比重将达到5%。随着AGI过程的持续深入,人工智能的触角借助各类传感器进入物理世界,这个占比可能达到20%-25%。

即便如王坚院士在WAIC2024上所说“对照算力设施,我国当下的能源是过剩的”,那从经济效益角度出发,当下的智算中心能效比也是急需改善的。有人测算,某著名长文本大模型每进行一次200万长文本推理的成本是8-10块钱,降低成本的抓手一方面是算力设施,另一方面就是能效比。调查显示,智算中心每处理1G数据耗电量大概需要13kW·h,由此可见提高算力能效比是实现AI应用规模部署必须要过的一关。

针对以上困局,一方面需要政府牵头进行生态整合,从更宏观的维度带领中国AI走出困境。另一方面,需要基于当下有限的资源,最大程度发挥AI Infra的价值!对此,我们认为存在三个突破口:算力多元化、联接标准化、能源低碳化。

3、算力多元化

3.1算力芯片多元化

从应用场景看:AI Infra需要支撑各类业务,如大模型训练、推理、向量数据库、RAG(检索增强生成)、PFS高性能存储等。这些应用对算力的性能、精度、响应速度等方面有不同的要求。例如,大模型训练需要强大的FP16浮点计算能力;大模型推理通常采用FP8、INT8等方式进行量化计算;向量数据库属于计算密集型负载,需要用到强大的CPU算力。单一算力难以满足这种多元化的需求。

从供应保障看:AI芯片的“智子问题”会长期存在,依赖单一的供应源可能会面临供应中断、价格波动等巨大风险。通过多元化供应,可以降低因单一供应源出现问题而导致的业务中断或服务质量下降的风险。在竞争激烈的市场环境中,多元化算力供应也会促使厂商不断创新和优化自己的产品和服务。

可喜的是在芯片多元化方面,新华三等头部ICT设备厂商已经投入大量资源同大多数国产芯片厂商进行了开发适配工作,当前已经具备多元芯片算力的规模交付能力。

3.2算力架构创新

算力芯片多元化之后,在单芯片的计算效率仍然受到“摩尔定律”和“智子”效应双重压力下,未来3~5年,算力架构的创新是解决大模型集群训推效率问题的最有效出路之一。

我们知道,当下典型的AI服务器仅支持一套含8卡的OAI GPU模组,8张GPU卡之间通过私有的技术实现高速互联。随着模型参数规模不断增长,8卡模组限制了张量并行、MOE专家并行的规模,大量的机间通信流量需要通过Scale Out网络,不利于GPU芯片的有效算力得到充分发挥。我们应该重点关注如何将现有单体芯片通过更加灵活先进的架构组成高效的算力系统:

从服务器整机的维度——我们可以复用现有8卡OAI架构,单芯片封装两颗裸Die,实现算力翻倍。另一方面可以参考NVIDIA MGX架构,设计16卡方案,通过底板Switch芯片实现16卡互联,GPU与CPU通信依然采用PCIE链路。不过16卡方案给整机散热带来巨大挑战,需要综合考虑冷板式液冷的方案对GPU卡以及Switch芯片散热。同样的,基于16卡架构进行改善,一块GPU卡封装2颗Die也将带来算力密度的极大增加。整机维度的升级需要背靠OAM/UBB/EXP的标准化,OAI工作组在这里发挥了至关重要的作用,新华三等OAI标准制定者将持续加强对社区的贡献。新华三作为主力成员撰写了OAI2.0规范,后续我们也会持续关注OAI3.0对于架构创新的规划与设计。

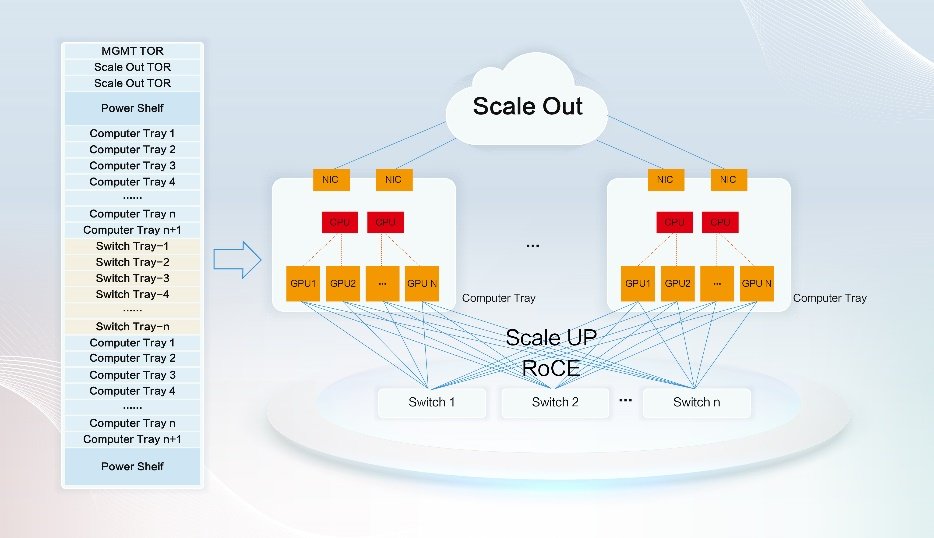

从集群系统的维度——可以考虑将更多的GPU互联起来,以Scale UP的方式提升整体算力。在互联技术的选择上,以太网技术凭借开放的生态、成熟的产业链、清晰的演进路径,成为当前非常理想的选择。目前,支持以太网接口的GPU产品日益丰富,可提供51.2Tbps交换容量的交换机在2023年已经商用部署,采用如下图所示的拓扑结构,可以在一个机柜内提供64个甚至更多个GPU,有效提升算力密度。

ODCC网络组在2024年启动了ETH-X超节点系列项目。该项目采用以太网技术构建HBD(High Bandwidth Domain)超高带宽域,将16卡以上的GPU互联起来,打造大型多GPU互联算力集群系统。

新华三作为ODCC成员单位,正在积极推动该项目的落地。

3.3异构资源管理

在同一个训练或推理任务中,算力多元与算力堆砌必然带来一系列问题:

不同厂商AI芯片的互联拓扑和互联带宽存在差异,并各自开发了相应的集合通信库,跨厂商的互联互通存在风险

不同厂商AI芯片软件栈不同,采用不同的运行时、编译器、算子库、加速库等,对AI框架和大模型的支持情况均存在差异

不同厂商AI芯片的算力、显存容量、显存速度等均存在差异,在模型并行时,难以进行负载均衡的模型切分

要解决上述问题,需要有一套强大的异构资源管理平台。能够兼容国内外主流 AI 芯片,最大程度上屏蔽硬件之间差异,帮助上层应用摆脱单一芯片依赖;能够对不同地点、规模、集群的智能算力进行统一、高效的管理,大幅提升智能算力效能;可以根据训推任务,实现更灵活的策略调度与任务编排。

要建设一套异构资源管理平台,可以从以下方面入手:

开发统一的集合通信库实现对不同厂商GPU的纳管,屏蔽不同厂商的差异:当GPU厂商的通信库开放时,可直接调用,实现统一纳管;当GPU厂商的通信库不开放时,可通过二次封装实现纳管。利用统一的集合通信库,可以实现不同GPU厂商利用RDMA协议进行互联互通。

提供统一的计算加速层,将不同GPU厂商的算子、加速策略、编译器等与上层应用解耦,GPU厂商可各自完成针对性算子调优。

在模型切分策略方面,异构计算平台利用掌握的不同GPU芯片算力、显存大小、显存速率等最佳实践数据,可快速计算出最优的任务切分策略,比如分配多少训练数据、切分多少模型层数等,确保整体效能最大化。

异构资源管理是当前技术创新的热点领域,也是工信部希望尽快解决的智算中心关键技术问题之一。在业界众多公司的努力下,正在不断取得新的进展:

百度百舸异构计算平台推出了多芯混合训练方案,将各类芯片融合成为了一个大集群,整合发挥这些算力的最大效能,支持更大模型训练任务。该方案不仅通过百度智能云的公有云提供服务,同时还可以通过ABC Stack专有云进行交付。

智源研究院推出了面向异构AI芯片的FlagScale高效并行训练框架,目标是在不牺牲稳定性和模型有效性的前提下,在不同的AI芯片上支持同一个训练任务。2023年11月发布的版本已经实现了NVIDIA GPU和天数GPU的异构混训。

新华三自主研发的傲飞算力平台提供从底层驱动到应用层框架整体技术栈,支持不同异构硬件的算子库、编译器、开发工具等,自研统一集合通信库UCCL,实现异构GPU统一通信、模型自适应切分,提供AI大模型训练/微调/评估/推理全流程开发服务。

以上就是算力多元化的全部内容,算力多元化是国内AI Infra破局的根基。

4、联接标准化

4.1联接协议标准化

网络是联接各算力单元和应用系统的纽带,打造开放解耦、灵活扩展的网络联接,是构建多元融合智算体系的关键所在。Scale Out和Scale UP网络需要满足GPU扩展性需求,承载GPU之间巨大的通信数据量,对提升智算中心的性能起着至关重要的作用,也是目前技术创新的热点。

Scale Out的演进趋势比较清晰。在现阶段,采用RoCE技术基本成为业界的共识。为了解决RoCE网络的问题,2023年7月,超以太网联盟 (Ultra Ethernet Consortium,UEC) 正式成立。UEC致力于从物理层、链路层、传输层、软件层改进以太网技术,在兼容当前以太网生态的前提下,使超以太网技术满足人工智能和高性能计算对网络的需求。因此,Scale Out网络未来向UEC演进是比较确定性的趋势。

Scale UP目前呈现出百家争鸣的状态:

NVIDIA使用NVLINK作为GPU Scale UP互联技术。目前NVLINK已经演进到第五代,底层使用224G PAM4 Serdes,将GPU之间的互联带宽提升到1.8TB/s,借助NVSwtich,最多可以把576个B200 GPU互联在一起。

国内GPU厂商通常会采用CCIX(Cache Coherent Interconnect for Accelerators)作为卡间互联协议,CCIX协议利用PCIe的物理层和数据链路层,互联带宽受限于PCIe的发展速度,互联规模通常只能做到8卡。

Intel Gaudi2和Gaudi3采用RoCE作为卡间互联协议,每个Gaudi3芯片提供21个200GE以太网接口用于实现和其他芯片的互联,可以提供1TB/s的卡间互联带宽,利用外置的以太网交换机,可以把64个以上的Gaudi3互联起来。

为了解决GPU间通信的传输瓶颈及标准化问题,2024年5月,AMD与Intel历史性联手,协同博通、思科、谷歌等企业成立UALink标准组织,提供GPU间通信的标准接口。 UALink 1.0标准预计在2024年Q3推出,带宽更高的UALink 1.1将于2024年Q4推出。

2024年6月,阿里云、中科院计算技术研究所及其他40余家企业联合发起成立了高通量以太网联盟,将在今年9月发布国内首个高通量以太网协议1.0,提出面向智算场景的网络解决方案,同时首次完整提出了针对集合通信的在网计算解决方案。

UEC/UALink/高通量以太网——最终落地并形成成熟的产业链均需要较长的时间。在现阶段,使用标准的RoCE技术统一GPU Scale UP及Scale Out网络是比较可行的方案。

RoCE在Scale Out网络中早已大规模商用部署,把RoCE引入到Scale UP网络有以下优势:

1、可以解决互联带宽问题,800Gps以太网已经商用部署,1.6Tbps以太网有望在2025年成熟商用,完全可以满足GPU间高速通信需求。

2、RoCE技术已经非常成熟,在GPU芯片中,通过UCIe等技术,引入支持RoCE的IO DIE,在技术和生态上相对比较容易实现。

3、通过优化集合通信库,可以有效规避网络拥塞,保障集群性能。

4、Scale UP网络规模可控、通信模式相对确定,完全有可能通过优化交换芯片的转发方式进一步降低时延

正是基于以上考虑,Intel提出了基于RoCE的Gaudi2/3 Scale UP方案;ODCC提出了前文所述的ETH-X超节点项目;新华三提供支持标准RDMA协议栈的以太芯粒方案。而面向高价值场景,新华三则推出了基于信元转发的FE/FAP半导体方案作为补充。

我们认为当下阶段以太RoCE就是统一Scale Out/Up网络的标准协议,当然了,我们也会持续关注UEC/UALink/高通量以太网协议的发展和落地。

4.2算网深度融合

算力和联接是AI Infra的双基石。对算力和联接进行最佳的调优和配合,实现算网融合,激发出“算力×联接”的乘数效应,将会对上层的AI应用提供更好的支撑。

如何将两者融合?基础方案是综合考虑GPU的卡间互联拓扑及网卡配置去选择合适的网络接入拓扑及模型切分方式,比如普遍采用的“多导轨联接”。接下来我们谈三点进阶方案:

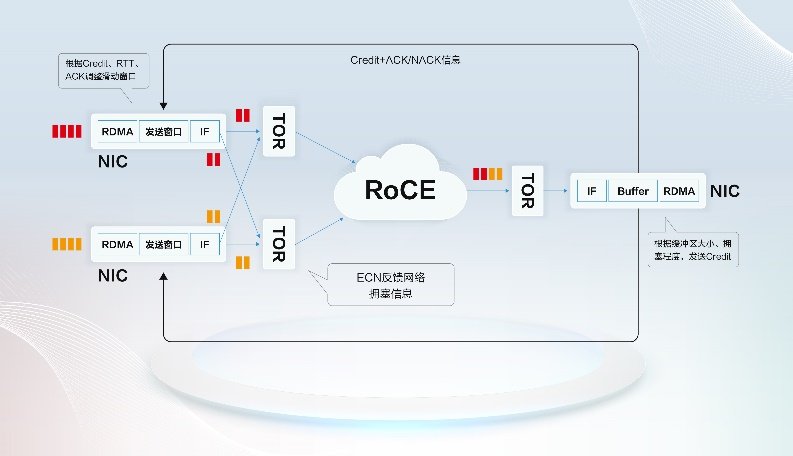

第一,需要将AI服务器、网卡、交换机当做一个整体, 结合创新的拥塞控制算法,实现端网协同,优化整个RoCE网络性能。在端网融合方面,Google、阿里、AWS等互联网大厂均已经基于私有的算法和协议实现落地。UEC也把端网融合作为重要的创新点,UEC在数据链路层提出了基于信用的流量控制(CBFC)机制,用于取代PFC流量控制;在传输层优化了拥塞控制机制。

新华三也正在投入算力网卡的规划,实现端网融合,总体思路如下:

拥塞控制方面,发送端基于接收端发送的Credit、ACK/NACK、RTT等信息,通过调整滑动窗口方式控制发送速率。在负载均衡方面,发送端选择适当的熵值,当反馈数据包表明与给定熵相关的路径拥塞时,修改熵值,交换机根据熵值进行逐包负载均衡,根据拥塞状态反馈ECN,接收端侧进行报文重组。

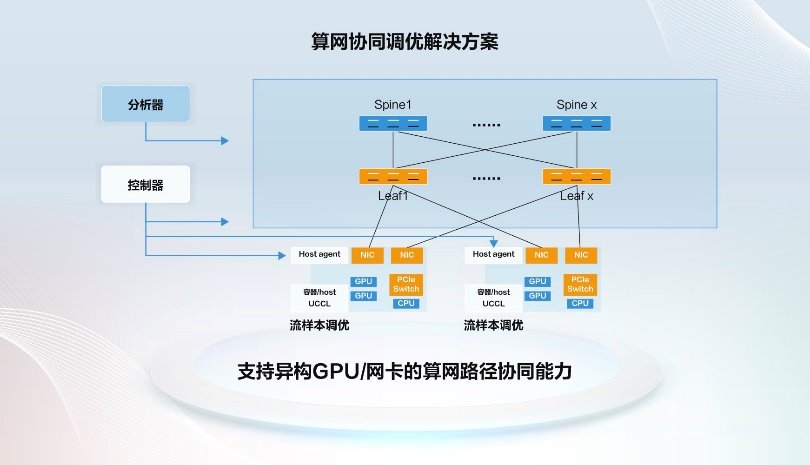

第二,通过将通信库、网络控制器、网络分析器结合起来,实现算网协同调度,如下图所示:

新华三开发了自研的UCCL统一通信库,UCCL上报AI服务器卡间互联拓扑及训练任务中节点间通信关系给控制器,控制器站在全局视角,统一规划转发路径,避免设备局部视角HASH不均问题,通过向交换机下发Traffic Matrix,指导设备转发,训练任务结束后,控制器根据UCCL上报的信息,删除相关任务。

第三,算力与网络在广域层面的融合成为强需求,算力网络应运而生。算力网络是一种将算力与网络深度融合的新型基础设施。它通过网络连接分布在不同位置的计算资源,包括数据中心、边缘计算节点等,并根据用户的需求和应用场景,对算力资源进行灵活的调度和分配。当前,国家正在大力发展“东数西算”战略,在西部数据中心进行大模型的训练,在东部人口稠密地区部署推理集群,训练数据和算力已不局限于单一的数据中心,新型计算任务和大量数据需要在多个算力中心间流转。

算力网络通过端侧、网侧和管控系统等多方协同,基于广域流量调度、传输协议优化、数据智能压缩等功能的完善,实现网络承载、智能管控、端侧优化的协同演进,满足业务快速开通、高通量传输的需求。

综上所述,通过联接标准化,能够打破AI基础设施内各种“看不见的壁垒”,让算力得以更灵活地调度和释放,给模型的训练、推理带来更高效、更稳定的支持。

5、能源低碳化

5.1加强算力碳效

从设备级维度来看,可以通过一系列技术创新来降低单位算力造成的能耗。这里介绍一项业界新型供电技术领域的热点话题:垂直供电。

目前典型的GPU峰值电流的需求高达2000A,在传统的水平供电架构中,电源和芯片被安置在同一平面上,从电源至芯片管脚的距离大约在2至3厘米。这种布局方式在高电流场景下导致了不可忽视的传输损耗。由于电源的功耗与电流平方和直流电阻(DCR)成正比,即P=I²*DCR,在高电流情况下,传统水平供电的损耗成为了主要的能耗问题。

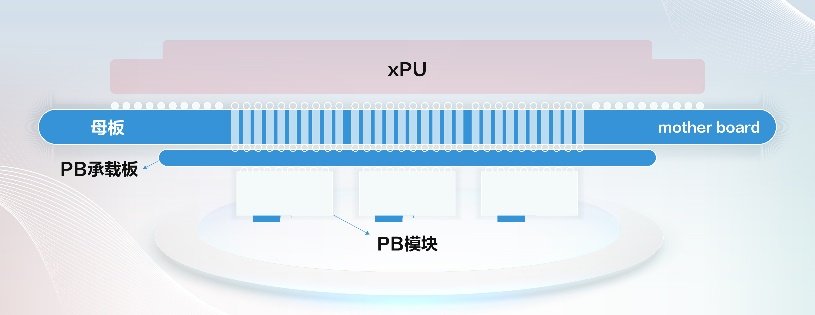

为了应对这一挑战,垂直供电方案应运而生,其将电源模块放置于芯片IC的背面,实现背靠背供电。通过打通印制电路板(PCB)的过孔,电源至芯片管脚的距离大幅缩减至PCB厚度,大约2至3毫米,从而大幅降低了传输损耗。

新华三积极投入垂直供电等新型供电技术的预研,并取得重要成果。新华三垂直供电解决方案采用标准的PB模块,自行设计PB承载板,形成成本更低的垂直电源方案。在制造工艺,尤其是焊接工艺方面,大芯片焊接本身难度大,且和垂直电源双面对贴,温度容易不均匀,翘曲风险大。新华三通过精确温度管控、焊锡量匹配、四角支撑方案等手段确保在整个生产过程中维持焊接质量,同时为维修保留一定的余量。

从系统级维度来看,需要增强能耗治理方案的智能化。以新华三AI能耗治理解决方案为例,可以通过AI Agent微服务进行全域数据采集,融合“云、网、端、安”等形成统一运维理念满足用户全域能耗管理要求。利用AI大模型等技术解决能耗管理中的异常、容量预测、根因分析等问题,从应用视角依托CMDB数据、资源关系和数据流形成拓扑视图,集成部署到U-Center大平台或独立部署,实现统一的设备及动力环境管理能力。利用能效管理模块实现对液冷设施、CDU设施、动力UPS及配电、环境及外围冷却设备的详细管理,通过AI算法实现对能耗异常的智能告警及自动调控,通过统一大屏实现能耗治理效果可视、基础设施能耗管理巡检、节电自动处理策略等,满足AI基础设施日益增长的能耗管理需求。

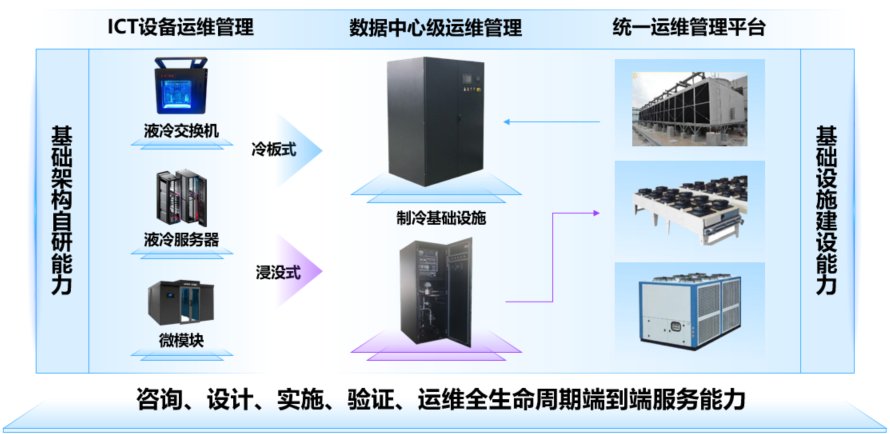

增强系统级碳效的另一个有效途径就是全栈液冷,全栈液冷需要具备五大关键能力:全生命周期服务、多元算力液冷、全液冷技术路线、便捷维护、安全可靠。通过全栈液冷可以打造稳定智能&节能高效的高碳效智算中心。

5.2加强区域资源利用

首先,需要加大绿色能源占比。绿色能源的充分利用是实现智算中心低碳发展的重要途径。太阳能、风能、水能等可再生能源具有清洁、低碳、可持续的特点,将其引入智算中心的能源供应体系,能够有效减少对传统化石能源的依赖,降低碳排放。其次,需要重视电网系统优化。例如源网储荷的协同发展,通过优化电源、电网、储能和负荷之间的协调配合,实现能源的高效传输和分配;再例如在电力供应充足时,将多余的电能储存起来,以备在用电高峰或电力供应不足时使用,从而实现削峰填谷,平衡电力供需,提高电网的稳定性和可靠性。

总之,推动能源低碳化是一项具有深远意义的任务,需要政府、企业和社会各界的共同努力,我们有信心实现智算中心的绿色低碳转型!

总结:

AI还有很长的路要走,我们需要清晰得认识到国内AI Infra的困局。而关于破局之道,本文中提到的三个观点也只是冰山一角。我相信只要业界齐心协力、聚沙成塔,我们终能走出一条山重水复到柳暗花明的道路!

免责声明:市场有风险,选择需谨慎!此文仅供参考,不作买卖依据。