随着以大模型、智能体(Agent)为代表的AI技术进入爆发式演进阶段,并加速渗透至千行万业,AI推理需求正呈现指数级增长。多样化、碎片化的应用场景,以及高并发、低延迟的实时响应要求,正在对现有AI算力基础设施的规模化供给、弹性调度与高效协同能力,提出前所未有的挑战与机遇。

华为与工商银行开展联合创新,成功落地Serverless NPU弹性算力调度技术方案。实测结果表明,相较于传统算力调度技术方案,Serverless NPU弹性算力调度技术方案可将千亿MoE大模型推理服务启动时间缩短至百秒级,启动效率提升10倍以上,实现算力供给模式从“长期绑定”向“按需使用”转型。

两大智算管理挑战

为了加速推进国家“人工智能+”战略,工商银行制定“领航AI+”行动计划,积极探索金融科技新质生产力。工商银行聚焦提升用户体验、提升业务效率、提升经营价值三大核心目标,构建自主创新的大规模算力集群,为“工银智涌”金融大模型技术体系建设提供算力支撑,打造以大模型为核心的新一代企业级金融业务赋能模式。

当前,AI算力集群调度主要存在两方面挑战。传统方案采用预分配机制,就像给推理任务分配了“固定车位”,虽能保障业务峰值时的算力供给需求,但已分配的算力资源会被持续占用,导致空闲时段有大量“闲置车位”,资源利用率低下;同时,模型文件通常过大导致加载速度慢,推理服务启动需耗时小时级,不仅导致算力供给难以实时响应突发负载变化,也无法与业务峰谷时段的需求实现精准匹配。

针对上述问题,华为云和工商银行开展联合攻坚,通过软硬协同的系统级优化,完成了Serverless NPU弹性算力调度技术方案的研发与验证。

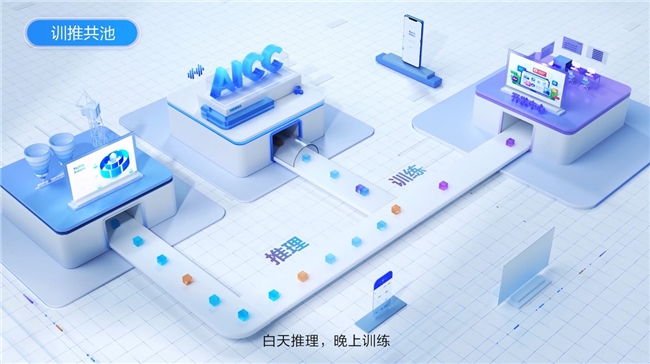

Serverless NPU弹性算力调度技术以ModelArts平台为核心,一方面通过多维快照技术,冻结保存推理服务稳定运行时的NPU状态、容器状态与进程状态,恢复时无需额外初始化,即可实现服务实例秒级启动;另一方面通过多维预编排技术,给大模型预先安排好“任务表”,提前切分模型权重、编排训推任务及加载镜像,实现算力资源“按需即用”的供给模式。借助昇腾底座到ModelArts平台的软硬件全栈协同,该技术端到端提升集群算力调度能力,推动算力调度从粗放式管理迈向集约型精细管控。

分钟级千亿模型推理实例启动

Serverless NPU技术方案在工商银行的实际测试结果显示,百秒内即可实现DeepSeek R1满血版等业界主流大模型的加载和推理服务实例的启动。

该技术已在工商银行内部广泛应用于细粒度动态资源池调度,借助分钟级推理服务启动能力,可实现资源池内训推任务精细化的快速切换,充分利用夜晚、周末等低谷期资源。

此外,该技术还支持推理实例的弹性扩缩容,包括基于时间预设的定时扩缩容和训推任务定时切换,以及由在线服务支持请求QPS、NPU利用率等指标触发的动态扩缩容,通过灵活调度实现“昼推夜训”和动态算力供给,有效压缩算力空置窗口。

在实际生产中,算力集群从上午7点到晚上11点运行DeepSeek推理实例,支撑工商银行财富助手、办公助手、智能审核等推理服务;晚上11点到次日上午7点则运行数智风控等训练任务。Serverless NPU弹性算力调度技术通过将训推任务切换时长压缩到分钟级,实现算力资源的高效流转,节约25%的算力资源。

迈向“随取随用”智算管理新阶段

华为云与工商银行的攻坚成果,不仅实现了算力资源的动态弹性调度,同时探索出一条高效利用算力资源的可行路径,印证了Serverless NPU弹性算力调度技术的广阔发展空间和潜力,标志着算力资源供给模式迈向“随取随用”的新阶段。

下一步,华为云将持续完善Serverless NPU弹性算力调度技术方案,推动其在面向客户的推理服务生产实践中深度落地,助力提升算力资源经营质效和客户体验,打造高弹性AI算力底座,为工商银行及更多金融客户的高质量发展注入新动能。

免责声明:市场有风险,选择需谨慎!此文仅供参考,不作买卖依据。