6月21日,腾讯混元文生图大模型(以下简称为混元DiT模型)宣布全面开源训练代码,同时对外开源混元DiT LoRA 小规模数据集训练方案与可控制插件ControlNet。

这意味着,全球的企业与个人开发者、创作者们,都可以基于混元DiT训练代码进行精调,创造更具个性化的专属模型,进行更大自由度的创作;或基于混元DiT的代码进行修改和优化,基于此构建自身应用,推动技术的快速迭代和创新。

作为中文原生模型,用户在通过混元DiT的训练代码进行精调时,可以直接使用中文的数据与标签,无需再将数据翻译成英文。

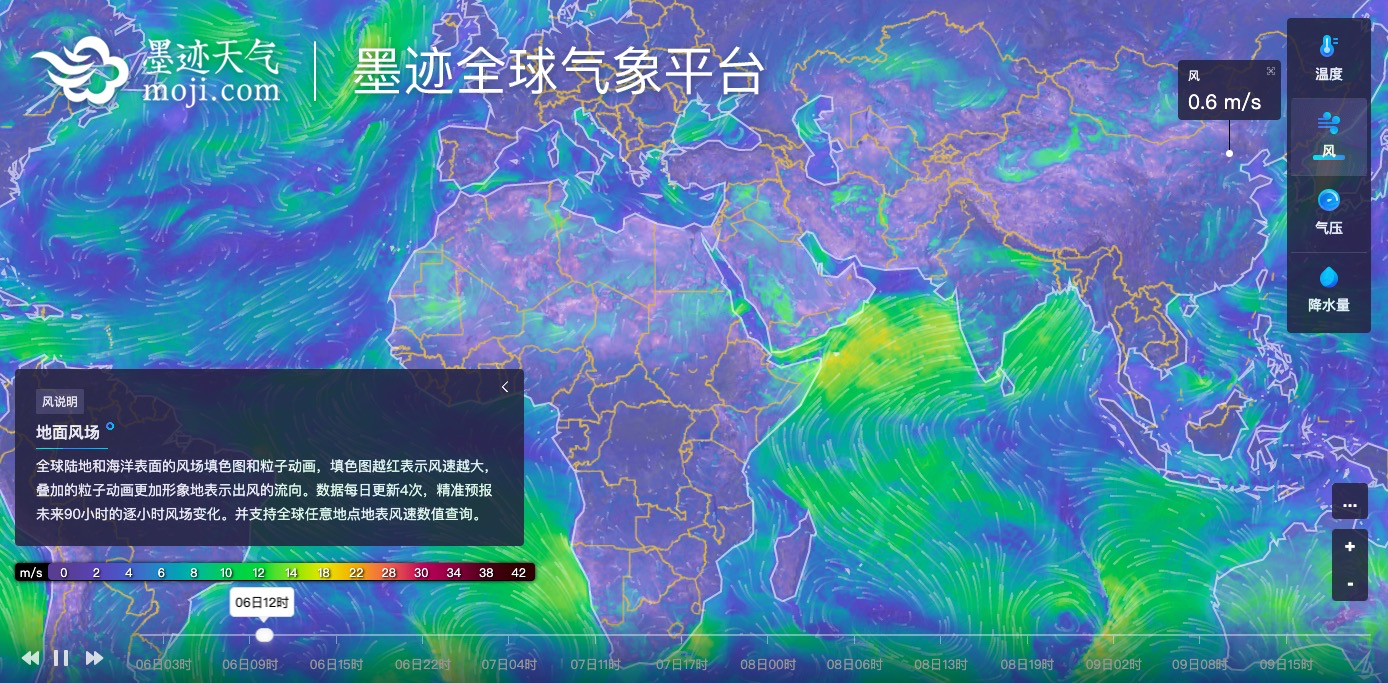

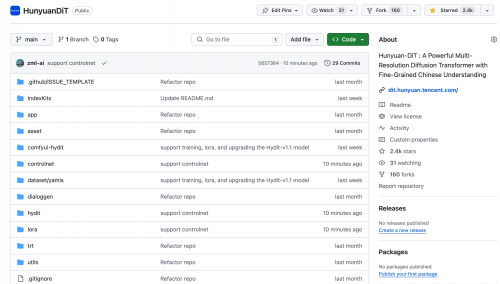

此前,腾讯混元文生图大模型宣布全面升级并对外开源,已在 Hugging Face 平台及 Github 上发布,可供企业与个人开发者免费商用。这是业内首个中文原生的DiT架构文生图开源模型,支持中英文双语输入及理解。模型开源仅一个月,Github Star数达到2.4k,位于开源社区热门DiT模型前列。

混元DiT Github项目页面

在开源训练代码的同时, LoRA小规模数据集训练方案与可控制插件ControlNet的发布也让混元DiT模型的开源生态更具想象力。

LoRA模型,全称Low-Rank Adaptation of Large Language Models,是一种用于微调大型语言模型的技术。在文生图模型中,LoRA被用作一种插件,允许用户在不修改原有模型与增加模型大小的情况下,利用少量数据训练出具有特定画风、IP或人物特征的模型。

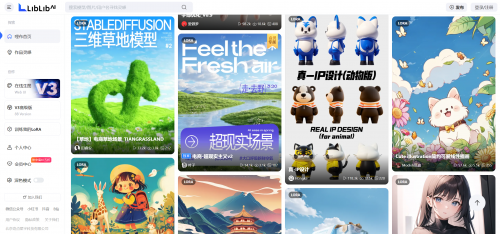

LoRA技术在文生图开源领域十分受欢迎,大量的创作者利用这种技术创造出多种多样的模型,比如使用几张个人照片,生成一个专属于某个人的高精度照相馆;或创造出盲盒、黏土等风格模型。

AI图像社区LiblibAI上的LoRA模型

混元DiT本次发布的专属LoRA插件,支持开发者最少仅需一张图即可创作出专属的模型。比如,导入四张青花瓷图片与相应的提示词,即可完成模型训练,创建了一个“青花瓷”生成模型:用户输入简单提示词,即可生成想要的青花瓷图像。

部分训练数据:

训练后模型的推理结果示例:

使用混元DiT LoRA训练的青花瓷生成模型

本次上线的另一个插件ControlNet,则是一种应用于文生图领域的可控化生成算法,它允许用户通过添加额外条件来更好地控制图像的生成。

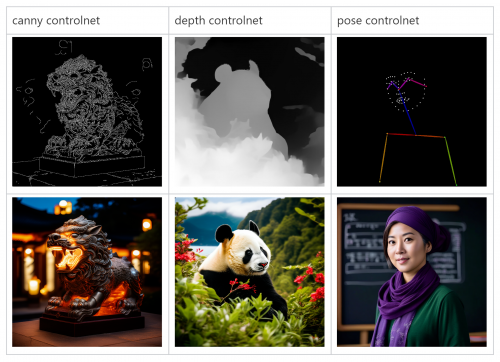

目前,腾讯混元提供了能提取与应用图像的边缘(canny)、深度(depth)、人体姿势(pose)等条件的三个首发ControlNet模型,让开发者直接使用其进行推理。该三个ControlNet插件能实现通过线稿生成全彩图、生成具有同样深度结构的图、生成具有同样姿态的人等能力。同时,混元DiT也开源了ControlNet的训练方案,开发者与创作者可以训练自定义的ControlNet模型。

腾讯混元DiT上线的三个ControlNet插件效果演示

自混元DiT模型开源以来,得到了众多开发者的支持和反馈,腾讯混元团队也一直在持续完善和优化基于混元DiT的开源组件,与行业共建下一代视觉生成开源生态。本月初,混元DiT发布的专属加速库,可将推理效率进一步提升,生图时间缩短75%。同时模型易用性大幅提升,用户可以基于ComfyUI的图形化界面,使用混元DiT,或者通过Hugging Face Diffusers通用模型库,仅用三行代码即可调用混元DiT模型,无需下载原始代码库。

据了解,腾讯混元文生图能力已广泛被用于素材创作、商品合成、游戏出图等多项业务及场景中。今年初,腾讯广告基于腾讯混元大模型发布了一站式AI广告创意平台腾讯广告妙思。《央视新闻》《新华日报》等20余家媒体也已经将腾讯混元文生图用于新闻内容生产。